Hallo Planeten, Mond, Doppelstern und Sonnenfotografen,

mich interessiert es, ob ich, wenn ich mit meinem C11 (2800mm f/10) ohne Brennweitenverlängerung arbeite, Details verlieren könnte. Die ASI-Kameras haben ja sehr kleine Pixel (3,75µm) und theor. könnte das ganz knapp ohne Verlust klappen.

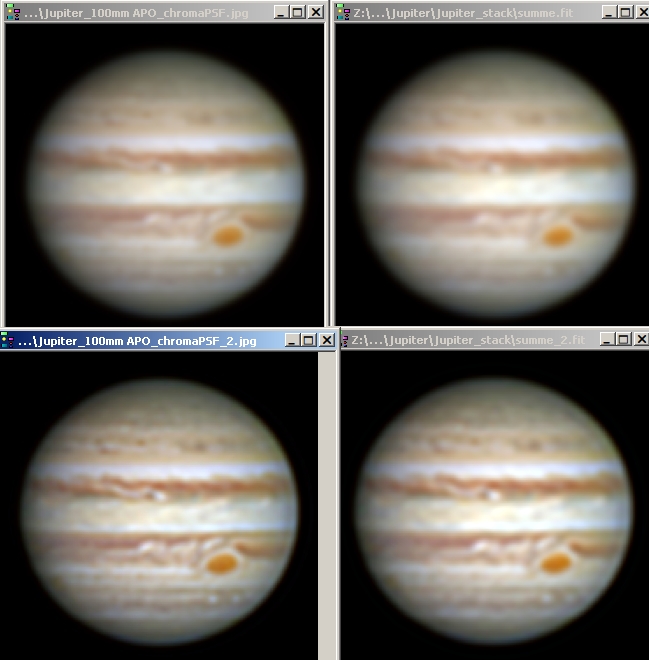

Im Praxistest konnte ich ein Sternscheibchen sauber abbilden und nach der Schärfung alle Beugungsringe auch sauber trennen. Reicht das als Argument schon aus?

Die gängigen Formeln kenne ich und habe meine Werte eingesetzt, es gibt aber ein paar "Variablen", und ich weiß nicht, wie ich diese bewerten soll.

Wenn man die Auflösung nach Nyquist beurteilt, dann wird die diagonale Auflösung ja gar nicht mit berücksichtigt, ist diese überhaupt wichtig?

Des weiteren ist die Wellenlänge ja für das theor. Auflösungsvermögen wichtig. Reicht im Roten möglicherweise f/10 und im Grünen nicht?

Wenn man so "knapp dran" ist, dann ist das Drizzeln vielleicht eine echte Option um wirklich mehr Auflösung zu erreichen.

Wie muss ich ´Auflösung´ überhaupt in der Planetenfotografie definieren? Wenn ich 2 Punkte habe, die teilweise miteinander "verschmolzen" sind, dann kann ich diese durch Schärfung wieder trennen, gilt das dann als aufgelöst?

Ich hätte natürlich gerne eine Antwort, "ja, du kannst", oder "nein, das geht nicht", vermutlich ist es aber schwieriger, auch im Hinblick auf die Softwaren, die ja bestenfalls auch subpixelgenau arbeiten müssten. Ich bin auf eure Meinungen, und Rechenkünste gespannt.

Viele Grüße,

ralf