Hallo Heiko,

danke für die interessanten Links.

<blockquote id="quote"><font size="1" face="Verdana, Arial, Helvetica" id="quote">Zitat:<hr height="1" noshade id="quote"><i>Original erstellt von: Doc HighCo</i>

<br />Mag jeder, den es interessiert, selber seine Schlüsse daraus ziehen.<hr height="1" noshade id="quote"></blockquote id="quote"></font id="quote">

Worauf du mit den Links abzielst, ist mir nicht klar. Vielleicht verstehe ich ja die Analyseergebnisse von Dr. Glover total falsch, aber eigentlich belegen sie doch meine Annahmen, zumindest prinzipiell.

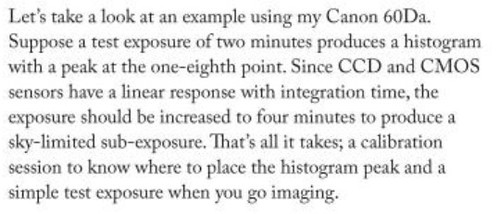

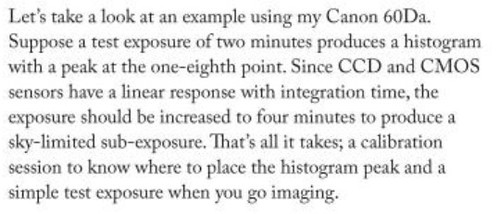

Blair MacDonald's Papier geht mit seiner Beschreibung der Zusammenhänge zwischen Rauschen und Aufnahmeanzahl insgesamt knapp an unseren Diskussionsthemen vorbei. Was die Aufnahmedauer angeht, hebt er auf die Himmelshelligkeit als wesentliche Einflussfaktor ab. Er verortet den optimalen Punkt für Canon Kameras bei 25% Histogramm und ist für sich selber offenbar in der Gegend von 4 Minuten Einzelbelichtungszeit:

Ich finde keinen Hinweis darauf, dass Kurzbelichtungen Vorteile gegenüber Langzeitbelichtungen bringen. Er plädiert i. W. für ausreichend hohe Bilderstapel.

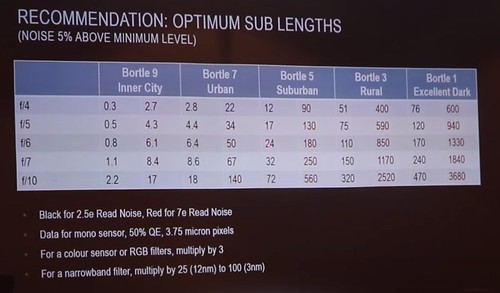

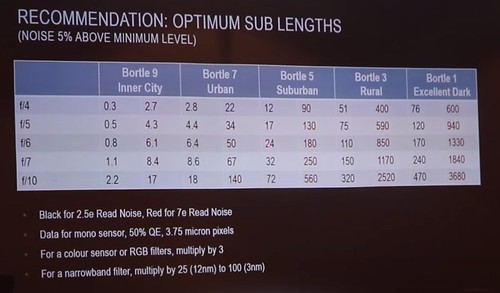

Der verlinkte Vortrag von Dr. Glover (der hat die Sharpcap-Sensoranalyse programmiert, glaube ich) lässt denn auch nach meinem Verständnis wenig Raum für einen anderen Schluss, als dass Kurzbelichtungen bei Deep Sky nur in lichtverschmutzen Gegenden Vorteile bringen. Glover präsentiert seine Ergebnisse für die optimale Belichtungszeit seines "Mustersensors" ab ca. 53:20 Filmzeit. Die "optimale" Belichtungszeit ist i. W. abhängig vom Öffnungsverhältnis, der Himmelsqualität und den verwendeten Filtern. Die Ergebnistabelle sieht so aus (die Zahlen für einen CMOS Sensor stehen in jedem Block links, die für CCD rechts):

Ich habe seine CMOS-Ergebnisse mal in Excel-Grafiken übertragen und Screenshots gemacht, damit man besser sieht, was passiert. Die Datei habe ich euch hier in meiner Dropbox abgelegt: https://www.dropbox.com/s/vvit…bellen%20glover.xlsx?dl=0. Wenn man keine Sharpcap-Vollversion hat oder auf die Sensoranalyse verzichten will, kann man sich daran vielleicht ganz gut orientieren. F/10 und die Wüstenhimmel Bortle 1 und 2 habe ich weg gelassen. Da sind die optimalen Belichtungszeiten besonders bei Verwendung von Filtern von vorneherein so lang, dass sie die Grafik sprengen.

Für einen Monosensor <b><u>ohne</u></b> Filter sieht das Ergebnis für optimale Einzelbelichtungszeiten so aus:

Mein Balkon hat in den besten Nächten etwa Bortle 4, schätze ich. Mit meinem F/7 System bin ich also etwa bei 90s Belichtungszeit. Klaus wäre mit seinem F/5 System auf meinem Balkon bei etwa 45s. Jedoch hat er einen RGB Sensor und die Zeiten sind zu verdreifachen:

Mit RGB Filter wäre ich bei 270s und Klaus mit seiner OSC bei 140s.

Für meinem 3nm OIII Filter muss ich schon eine logarithmische Darstellung wählen:

Die Grafik zeigt, ich sollte mit Schmalbandfiltern so lange wie möglich belichten. Meine Beschränkung würde ich bei gegebener Gesamtbelichtungszeit dadurch setzen, dass ich mindestens 30-50 Aufnahmen haben möchte, um das Rauschen unten zu halten. Deswegen fotografiere ich i. d. R. mit 300s Belichtungszeit, wenn ich meinen Chroma 3nm OIII vor dem Sensor habe.

Der Vortrag von Dr. Glover lässt mich den gleichen prinzipiellen Schluss ziehen, wie schon mal oben formuliert. Je besser der Himmel (und je enger der Filter) desto länger die Belichtungszeit.

Extreme Kurzbelichtungen finde ich sinnvoll, wenn man in der Stadt fotografiert oder bei viel Mond und/oder wenn man keine gute Nachführeinrichtung hat. Setzt man die Kurzbelichtungstechnik bei dunklerem Himmel ein bzw. bleibt man in den Diagrammen "unter" den jeweiligen Kurven, verschenkt man Qualität. Die Aufnahmen werden dann bei gegebener Gesamtbelichtungszeit schlechter als bei längeren Einzelbelichtungen. Die hier diskutierten 10s und weniger Belichtungszeiten machen lt. Dr. Glover erst bei schlechterem Himmel als Bortle 7 Sinn. Die Strategie eines "100 x 10s Kurzbelichtungs-Livestacking" kann hier auch keinen Vorteil bringen. Aus den schon zuvor beschriebenen Gründen vermute ich sogar zusätzliche Nachteile.