Ich hab noch immer die Vorstellung, dass das nicht ganz linear geht. Solange das Seeing eine Spreizung weit unter der Auflösung des Teleskops macht, bleibt das Beugungsmuster für die Abbildungsleistung entscheidend. Und dabei ist wichtig, dass die Auflösung normalerweise nicht durch das gesamte Beugungsmuster bestimmt wird sondern, und das auch bei großen Obstruktionen, durch den Durchmesser des Beugungsscheibchens (je nach Definition). Sobald jedoch das Seeing die Auflösung erreicht, springt die gesamte Spreizung auf eine Größe über das Beugungsmuster, ab hier kann man dann einfach addieren.

Aber genau dieser Bereich, wo die Spreizung durch Seeing bei der Aufkösung des Gerätes liegt, ist das ganze nicht linear, sondern steigt ziemlich sprunghaft an mit dem Seeing. So wenigstens stelle ich es mir vor. Und das ist ja häufig der Fall bei Öffnungen zwischen 4 und 8 Zoll, dass das Seeing genau in diesem Bereich liegt

Aber glaubst du auch, dass man prinzipiell aus dem Beugungsmuster an einem Stern schon sehr viel, wenn nicht alles, über die Qualität der Optik lesen kann? Diese Frage ist nur halb rhetorisch.

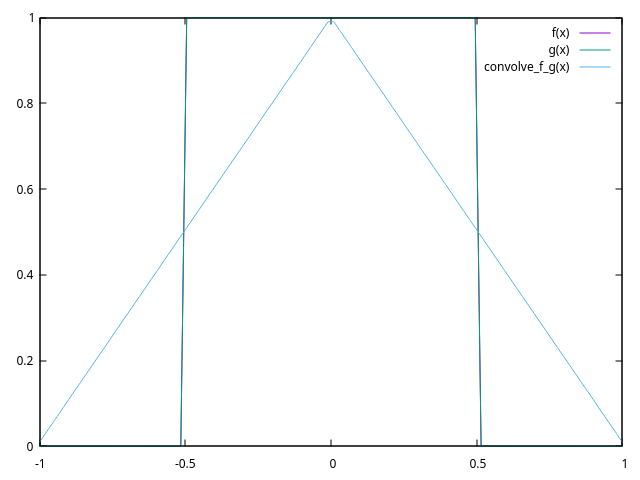

Finden wir es raus. Gnuplot ist eine freie Software für Graphen (gibt es auch für Windows):

gnuplot download

Es ist hier und da etwas obskur, aber ich nehme es schon ewig und Du kannst es bei Dir so nachvollziehen. Zum Einstieg erstmal die Rechteckfunktion:

box(x)=abs(x)<=0.5 ? 1 : 0

Gnuplot kann Funktionen nicht als Argumente übergeben, also nehme ich zur Faltung immer f und g:

f(x)=box(x)

g(x)=box(x)

Die Faltung ist das numerische Integral über den Phasenversatz, hier von -10 bis +10 in Schritten von 1/100:

eps = 0.01

convolve_f_g(x) = sum [offset=-10*100:+10*100] f(offset*eps)*g(x-offset*eps)*eps

plot [-1:1] f(x),g(x),convolve_f_g(x)

Tut's, die Dreiecksfunktion. Weiter mit dem Beugungsscheibchen (zur Übersichtlichkeit normalisiert und für 0 definiert, damit die Integration klappt):

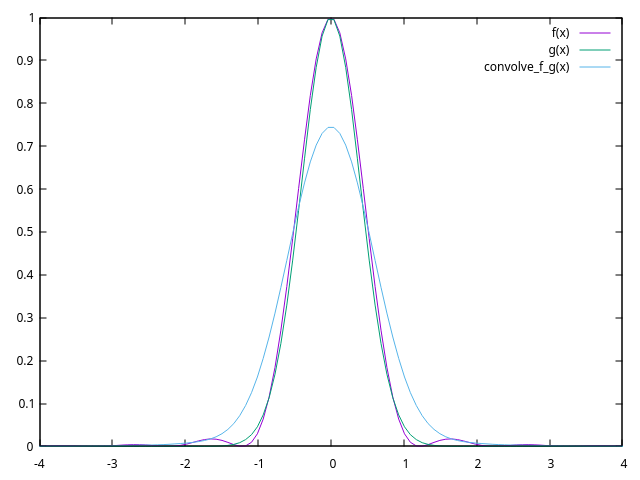

airydisk(x) = x==0?1:((2*besj1(pi*x))/(pi*x))**2

Wie soll das Seeing sein? Exzellent mit einer Standardabweichung von 0.3 Beugungsscheibchen und ich normiere es für die Übersichtlichkeit auch auf 1 in der Mitte:

gauss(x,stddev,my) = 1/sqrt(2*pi*stddev*stddev)*exp(-0.5*((x-my)/stddev)**2)

seeing(x) = gauss(x,1.22/3,0)/gauss(0,1.22/3,0)

f(x) = airydisk(x)

g(x) = seeing(x)

plot [-4:4] f(x),g(x),convolve_f_g(x)

Also wenn Seeing und Beugung etwa gleich sind, wächst das Scheibchen von Radius 1.22 auf ca. 2 und wird im Kern ein wenig dunkler.

Damit kannst Du jetzt selbst schauen, wie Beugung und Seeing die PSF verändern. Und wenn Du die Funktion für die PSF mit Obstruktion auftreibst, auch die originale Frage beantworten. Man sagt, dass Seeing selten besser als 1 Bogensekunde wird, aber ich habe keine Ahnung, was man da eigentlich genau misst. Der Bezug zur Realität wäre also noch herzustellen.

Deine Frage mit dem Stern als Punktfunktion kannst Du damit auch testen:

star(x)=x==0?1.0/eps:0

Da mit einem epsilon von 0.01 integriert wird, muss die Punktfunktion der Kehrwert von epsilon sein. Wenn man analytisch integriert, wird die als Grenzwert unendlich. Die Faltung mit der Punktfunktion ergibt wieder die originale Funktion.

Prinzipiell steckt in der PSF alles, wenn man berücksichtigt, dass sie nicht über das Feld konstant ist. Suiter kann an der PSF alles ablesen, ich kann's nicht.

Michael