Hallo Zusammen,

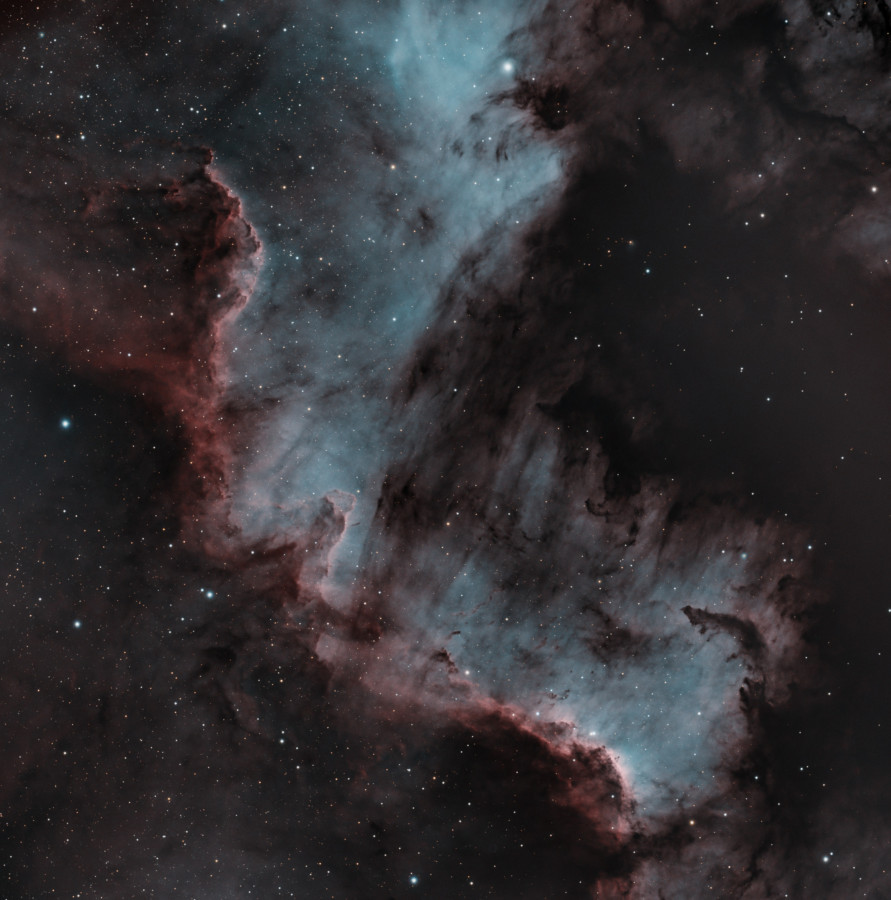

meine letzte Aufnahme mit einem dual-narrowband Filter liegt mit Dezember 2021 schon eine Weile zurück. Schmalband habe ich dann seit Anfang 2022 mit einer 294MM aufgenommen. Nun sind die Nächte wirklich kurz und hier im Norden wird schon seit einigen Wochen keine astronomische Dunkelheit mehr erreicht. Dann leuchte der Mond mit 85-92% Illumination in den letzten beiden Tagen auch noch dazwischen und ich wollte mal wieder einen kombinierten Schmalbandfilter für Ha und OIII ausprobieren und zwar den Antlia ALP-T. Die FWHM ist mit jeweils 5nm nicht ganz so gering wie beim L-Ultimate, jedoch wird man evtl. mit weniger Halos belohnt. Glücklicherweise waren die letzten beiden Nächte fast wolkenfrei und ich konnte insgesamt 6h15 min belichten. Da es hier in Berlin nicht nur durch den Mond und die Jahreszeit recht hell ist und ich nur mit f/7 unterwegs war, ist meine Erwartungshaltung nicht übermäßig groß gewesen. Mit den gesammelten Daten bin ich aber ganz zufrieden und das hier ist dabei herausgekommen.

CS - Oliver

">

(5. und 6.7.2023, Berlin, Bortle 6+, 107PHQ, f/7, ASI 533MC, Gain 100, 75 Lights jeweils 5min, Darks, Flats, Bias, Antlia ALP-T Filter, pre- und post-processing mit PI)