Hallo,

angespornt durch die tolle Darstellung des Pulsierens des Pulsars im Krebsnebel im Thread:

http://www.astrotreff.de/topic.asp?TOPIC_ID=257999

habe ich nochmal eine etwas ältere ultrakurzbelichtete Bildserie vom Februar 2017 bildbearbeitungstechnisch durchgesehen und ich habe auch das Problem gefunden, warum ich damals ohne Ergebnis aufgegeben habe. Aber zuerst das Resultat:

(Leider sind alle Bilder in x und y gespiegelt, ich bitte um Entschuldigung)

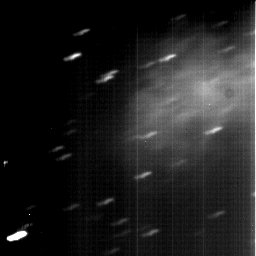

Bild1: Krebsnebel M1 mit Pulsar NP 0532 (rechts oben), Aufnahmedatum 21.01.2017. Pulsarperiode 33,371ms, dargestellt mit jeweils 3,4ms Einzelbildern, welche aus jeweils phasenrichtigen Stacken von 7600 Einzelbildern mit 5ms Belichtungszeit (38s pro Phasen-Bild) entstanden sind.

Bild2: 3x Vergrößerte Darstellung

Die Aufahmebedingungen waren damals:

Aufnahmedatum: 21.01.2017

Teleskop: Meade 12" ACF mit 3000mm Brennweite

Kamera: ANDOR IXON 897D EMCCD (16µ Pixel, 90%QE, -80°C Kühlung) mit 300x EM-Gain, nur Luminanz

Einzelbelichtungszeit: 5ms

Bildserie: ~76000 Einzelbilder

Bildfolge/Kadenz: 34,99ms (Bildfrequenz bei 256x256 und 5MHZ Auslesefrequenz)

Bild3: Bildfolge von 100 Einzelbildern zur Veranschaulichung, Bei 5ms Belichtungszeit ist nur 1 Stern mit etwa 11mag links unten zu erkennen. Der Bildausschnitt wurde extra so eingestellt das dieser Stern gerade noch mit drauf ist, da das die einzige Möglichkeit für ein Alignment ist.

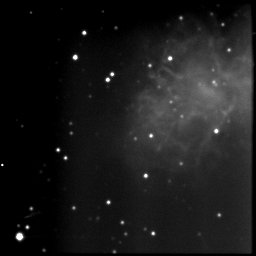

Bild4: Summenbild ohne Alignment

Bild5: Summenbild mit Alignment, Grenzgröße ist etwa 19mag bei 380s Gesamtbelichtungszeit. Der Hintergrund ist etwas "wellig", die Kamera fühlt sich bei solch extrem kurzen Belichtungszeiten nicht so ganz wohl.

<b>Wo war 2017 der Fehler und wie habe ich es jetzt gemacht?</b>

Kurzum habe ich nicht gut genug zum Pulsar recherchiert und es war auch eine ganzschöne Datenschlacht mit vielen Fehlversuchen. Es ist nämlich extrem wichtig, dass die Periode des Pulsars und das Bildaufnahmetiming bei den tausenden Bildern auf Bruchteile von µs bekannt ist und auch ausreichend stabil über die Aufnahmedauer (~2700s) bleibt.

Nach neuerlicher Untersuchung sind folgende Parameter herausgekommen:

<b>(Berechnete) Pulsarperiode (21.01.2017): 33,371ms</b>

(habe ich per Excelsheet und den aktuellen Timingparametern gerechnet, ändert sich schon merklich, aktuell ist sie bei 33,378ms)

<b>Bildfolge/Kadenz: 34,98285ms</b>

(musste ich exakt mittels FFT bestimmen, alles andere funktioniert nicht)

Damals hatte ich mit ungenauen und auf 2 Nachkommastellen gerundeten Werten gerechnet. Das geht dann nur über einige 100 Bilder gut, dann läuft das Stacking aus der Phase. Es ist halt leider eine doch recht lange Bildfolge über 76000Bilder notwendig.

<b>Praktisch, bzw. Softwaretechnisch habe ich das unter Verwendung von ImageJ (bzw. AstroImageJ) realisiert. [Ich liebe das Programm :)]</b>

- alle Bilder sind abfolgerichtig in einem TIFF-Bildstack von insgesamt 9,2GB gespeichert

- ich lasse ImageJ per skript die Bilder durchzählen und das Programm berechnet die jeweilig Phase des Bildes mittels der exakten Pulsarperiode sowie der genauen Bildkadenz und der Position des Einzelbilds im Stack

- das Programm schreibt dann in die Einzelbilder des TIFF-Stacks den Label als Metadaten, wobei im Label die ausgerechnete Phase steht

- anschließend kann ich die Bilder automatisch nach dem Phasenlabel sortieren, bzw. in Bins eingruppieren

- Stacken und fertig

- kann man mit dem ImageJ alles komplett skripten und vollautomatisiert durchlaufenlassen

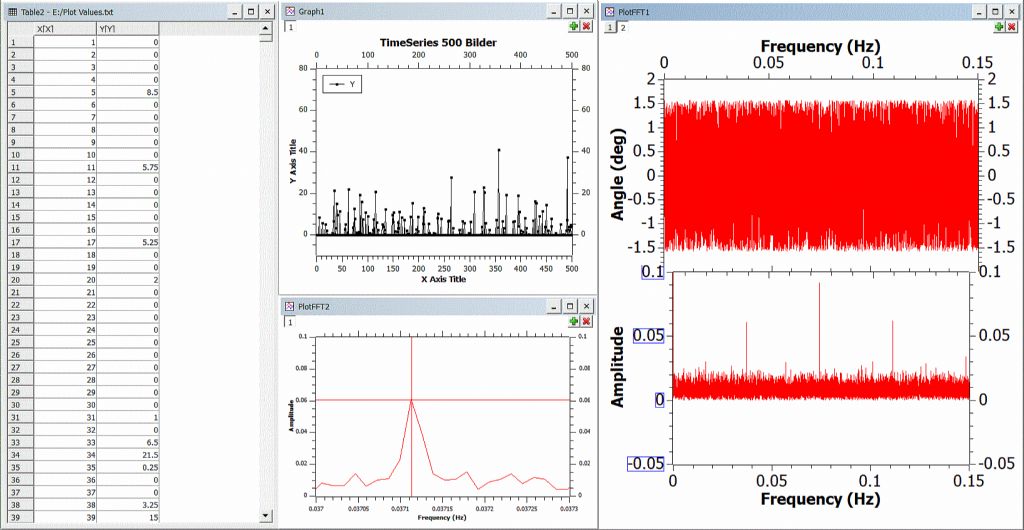

Die für die phasenrichtige Berechnung erforderliche Bildkadenz, bzw. die Phasenverschiebung habe ich mit ImageJ und QtiPlot bestimmt. Ist schon etwas trickreich, da faktisch nur einzelne Photonen ankommen:

1. 4 Pixel an der Position des Pulsars pro Bild summieren

2. in z-Richtung des Bilderstacks auswerten (plot z-axis profile)

3. diese Zahlenreihe exportieren und mittels QTIPlot importieren und eine FFT drüberlaufen lassen.

4. Position des/ bzw. der Peaks auswerten, siehe unten:

Bild6: FFT Auswertung mit QTIPlot

Mit der FFT kann man die Frequenz des Pulsars bezogen auf die Bildfolge superexakt auswerten. Die Messung ergibt, dass die Phase sich alle 1 / (0,037113 +- 0,00001) Bilder mit ausreichend hoher Genauigkeit wiederholt, nominell also alle 26,94473 Bilder. Thats it!

Vg Tino