Diese Frage ergibt sich aus einer parallel laufenden Diskussion über die Brennweitenanpassung von digitalen Videokameras am Beugungslimit einer Teleskopoptik.

Der Durchmesser des Beugungsscheibchens einer Punktlichtquelle (Stern) wird bei grünem Licht der Wellenlänge 500 nm näherungsweise mit 1,22 µm x f/D angesetzt, wobei f/D die Blendenzahl der abbildenden Optik ist. Bei einem für Newtonteleskope typischen Öffnungsverhältnis von f/5 liegt der Durchmesser bei 6,1 µm. Nach dem Rayleigh-Kriterium gilt die Abbildung eines Doppelsternpaars als optisch aufgelöst, wenn das Maximum des einen mit dem 1. Minimum des zweiten Beugungsbilds zusammenfällt, d.h. in dem betrachteten Fall von f/5 bei einem Abstand der Beugungsmaxima von rund 3 µm.

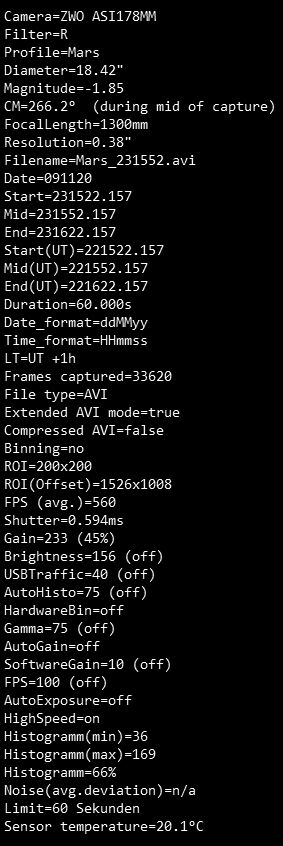

Zur optischen Abbildung von periodischen Strukturen mit der Ortsfrequenz f bedarf es nach dem Nyquist-Kriterium einer minimalen Rasterfrequenz von 2f, im obigen Beispiel also der Rasterauflösung 1,5 µm eines entsprechenden Kamerachips. Auf dieser Erkenntnis basiert offenbar die Empfehlung mancher Experten zur Verwendung von Barlowlinsen bei der Anpassung von Videokameras mit gößeren Pixelweiten. Bei einer Kamera mit 2,4 µm Pixelweite wäre demnach eine der Kamera vorgelagerte optische Brennweitenverlängerung um den Faktor 2,4 µm / 1,5 µm = 1,6 erforderlich.

Nun ist aber zu beachten, dass die obige Berechnungsmethode zunächst einmal nur für die starre Abbildung von Objekten gilt. Bei der videografischen Erfassung von Himmelsobjekten bewegt sich aber deren Abbildung infolge der Luftunruhe (Seeing) während der Aufnahme auf dem Kamerachip in erheblichem Umfang umher. Die Seeingamplitude ist insbesondere bei größeren Teleskopen um ein Vielfaches höher als der Durchmesser des Beugungsscheibchens der Optik, Beispiel: Bei einem Seeing von 2“ FWHM und einer Teleskopbrennweite von nur 1,27 m springt die Abbildung bereits innerhalb eines Radius von 6,2 µm auf dem Kamerachip umher.

Das wesentliche Merkmal der Videoastronomie besteht nun aber darin, dass man durch Kurzzeitbelichtung und Stacken auf die Detailstrukturen des abgelichteten Himmelsobjekts zentriert, und das Kameraraster dabei weitestgehend „ausgewischt“ wird. Für die Abbildung einer Objektstruktur an der Beugungsgrenze reicht es in dem hier beschriebenen Fall, dass diese Struktur nur „blickweise“ auf dem 1,6-fach gedrizzelten Raster des Summenbilds erscheint. Eine entsprechende Brennweitenverlängerung zur Anpassung des Kamerarasters gemäß Nyquist ist dann offenbar entbehrlich.

CS Jan