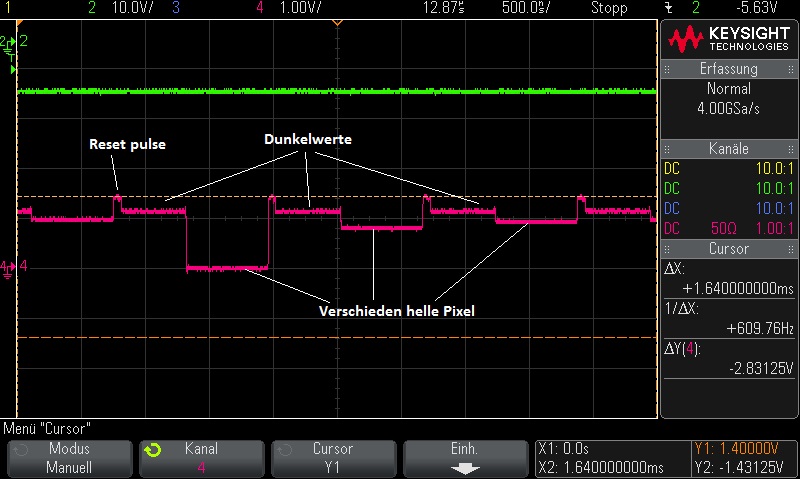

Wird etwas dauern bis ich hier wieder was berichten kann. Bin dabei die Schnittstelle zwischen PC und Kamera komplett neu zu programmieren. Das Kommandointerface, welches ich für die erste Inbetriebnahme gebaut hatte eignet sich nicht so gut für die Zusammenarbeit mit Programmen wie AstroArt. Auf der PC-Seite muß auch der Treiber entstehen. Das wird auch etwas dauern da ich seit Ende der 90er keine Software mehr für Windows geschrieben habe. Dort hat sich doch einiges getan.

![]()